在人工智能领域,神经网络如同精密的 "智能大脑",但庞大的参数规模使其在小型设备上运行时面临速度慢、耗电快等问题。量化技术作为模型压缩的重要手段,通过低比特数近似表示参数来 "瘦身",却因量化函数非可微的特性,易导致性能受损。我院师生提出 "多目标凸量化" 方法,为神经网络 "瘦身" 开辟新路径。不同于传统单目标优化,新方法采用 "双目标任务":既提升模型性能,又减小量化误差,如同让运动员既跑得快又动作标准。实验显示,该方法在多个数据集上表现优异,低比特量化下的神经网络模型准确率显著高于传统方法,参数更集中于量化值周围,误差可控。

本实验室师生完成的论文《Multi-Objective Convex Quantization for Efficient Model Compression》发表于《IEEE Transactions on Pattern Analysis and Machine Intelligence》(TPAMI)。该论文由本实验室樊春晓副教授、郭丹教授、汪萌教授等人合作完成。

论文简介:

论文标题:

Multi-Objective Convex Quantization for Efficient Model Compression

论文作者:

Chunxiao Fan,DanGuo,Ziqi Wang,Meng Wang

论文链接:

https://ieeexplore.ieee.org/document/10812914

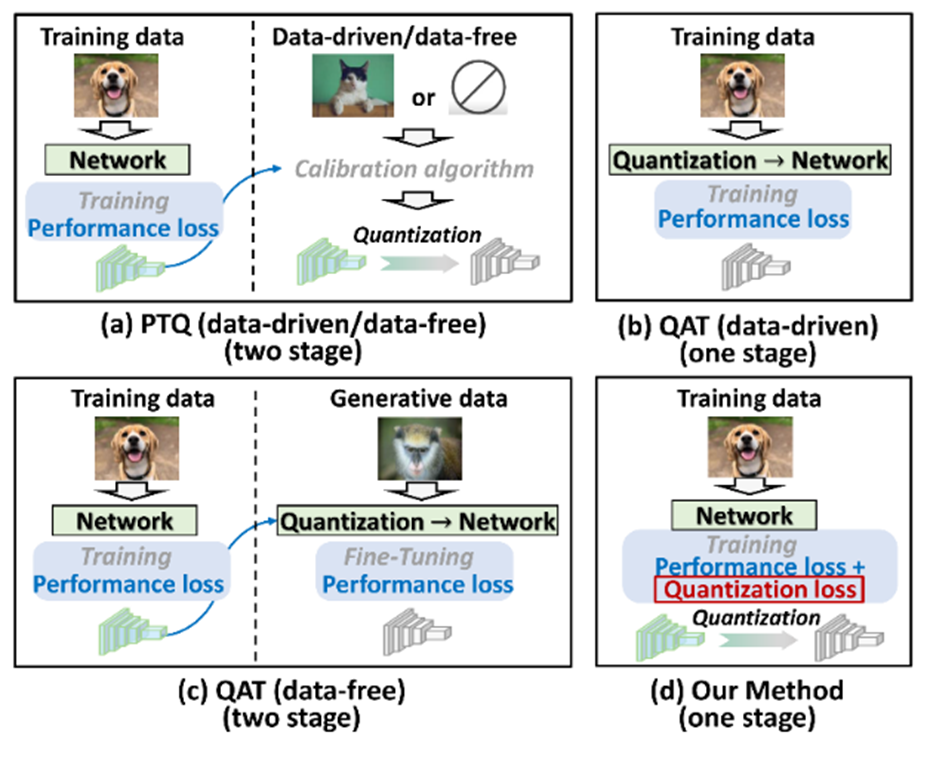

图 1 提出方法与现有方法对比

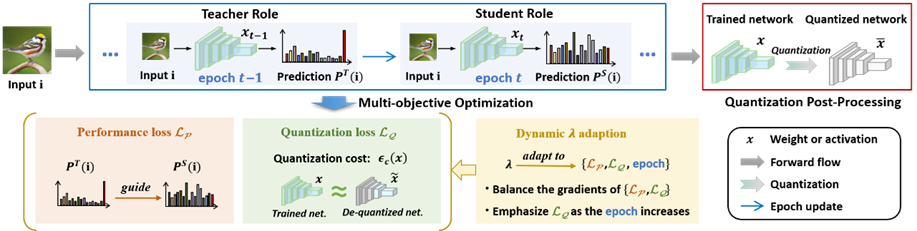

图 2 提出方法结构框图

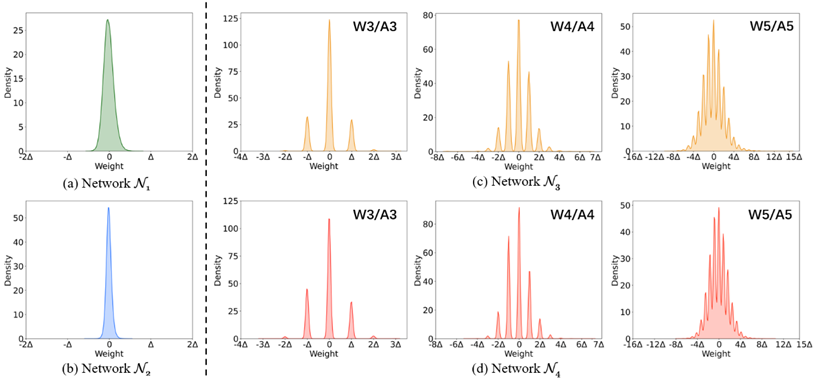

图 3 常规方法与本方法训练模型参数分布

该论文针对现有量化方法中因量化函数不可微导致的训练困难问题,提出了多目标凸量化方法。与现有方法不同,该方法将网络训练建模为多目标优化问题,通过联合优化模型性能和量化误差实现对量化操作的间接优化(如图1所示)。为解决多目标优化中的收敛、性能提升及目标平衡等挑战,设计了周期内可微凸量化误差函数、时间序列自蒸馏机制和动态拉格朗日系数自适应调整策略(框架如图2所示)。实验结果显示,在多场景数据集上表现优异,且模型参数集中分布在量化值周围(如图3所示),显著优于现有量化技术。

TPAMI是由IEEE计算机协会主办的顶级学术期刊,在模式识别、计算机视觉、机器学习等领域具有极高的学术影响力。其影响因子常年位居相关领域前列,对论文的学术质量、创新性和技术价值要求很高,收录的研究成果通常代表了该领域的最高水平是该领域的顶级期刊之一。

情感计算与先进智能机器安徽省重点实验室

2025年7月25日

科研动态

科研动态 2025-07-25

2025-07-25

安徽省合肥市蜀山区丹霞路485号(合肥工业大学翡翠湖校区)

安徽省合肥市蜀山区丹霞路485号(合肥工业大学翡翠湖校区) aflab_hfut@163.com

aflab_hfut@163.com